2. 山东理工大学 电气与电子工程学院,山东 淄博 255000

2. School of Electrical & Electronic Eng., Shandong Univ. of Technol., Zibo 255000, China

在视频监控场景中,对人群进行分析,判断是否有异常行为发生,是提高智能视频监控系统性能的关键,对于平安城市建设至关重要。由于人群行为的复杂和多样性,人群异常行为的检测(特征提取和建模)依然是一个具有挑战性的问题,近年来引起了研究人员的广泛关注[1–5]。

人群异常行为主要分为局部异常和全局异常两大类[6]。局部异常表现为个体行为不同于人群场景中其他个体的行为;全局异常为整个人群发生异常,如人群因为突发事件四散而逃。基于个体的方法[7–9]主要通过检测、跟踪和识别单个个体的运动轨迹,分析整个人群。这种方法在面对背景比较复杂或人群密度较高的视频流时,会因无法获取完整的信息而大大降低准确度。

基于全局异常的方法成为近几年人群异常行为检测的热点。该方法关注两个问题:运动特征提取和异常检测[6]。Direkoglu等[6]提出当前帧与前一帧在每个像素位置上光流矢量的角度差作为运动特征描述子,利用SVM学习正常人群行为,其特征描述子基于连续两帧间光流信息,欠缺对较长时间段中运动信息的处理能力。Simonyan等[10]引入光流法对连续视频帧进行运动特征的描述,此方法虽在人体行为识别工作中表现良好,却未在异常行为检测中应用。Hassner等[11]通过计算光流场幅度的变化,并结合支持向量机(SVM)对人群暴力事件进行检测,实时性较好,但对于小规模人群的暴力事件,检测效果较差。熊饶饶等[12]利用混合高斯模型提取视频中的人群运动前景,并通过等间距抽样法使用Lucas–Kanade法计算特征点的光流场,统计全局特征点的光流方向直方图、光流大小直方图和光流加速度直方图,将三者融合的结果作为人群特征,并使用SVM作为异常检测方法,但该方法缺乏对运动目标空间特征的准确描述。

针对以上研究方法存在的不足,本文提出一种基于脉线流和时空流网络模型的人群异常行为检测算法。首先,为准确描述人群运动信息,引入基于脉线流方法进行运动特征的提取。然后,为解决传统算法缺乏对空间特征建模的不足,提出改进的时空流卷积神经网络模型,获取群体运动的空域和时域特征。最后,结合两种特征给出异常检测结果。

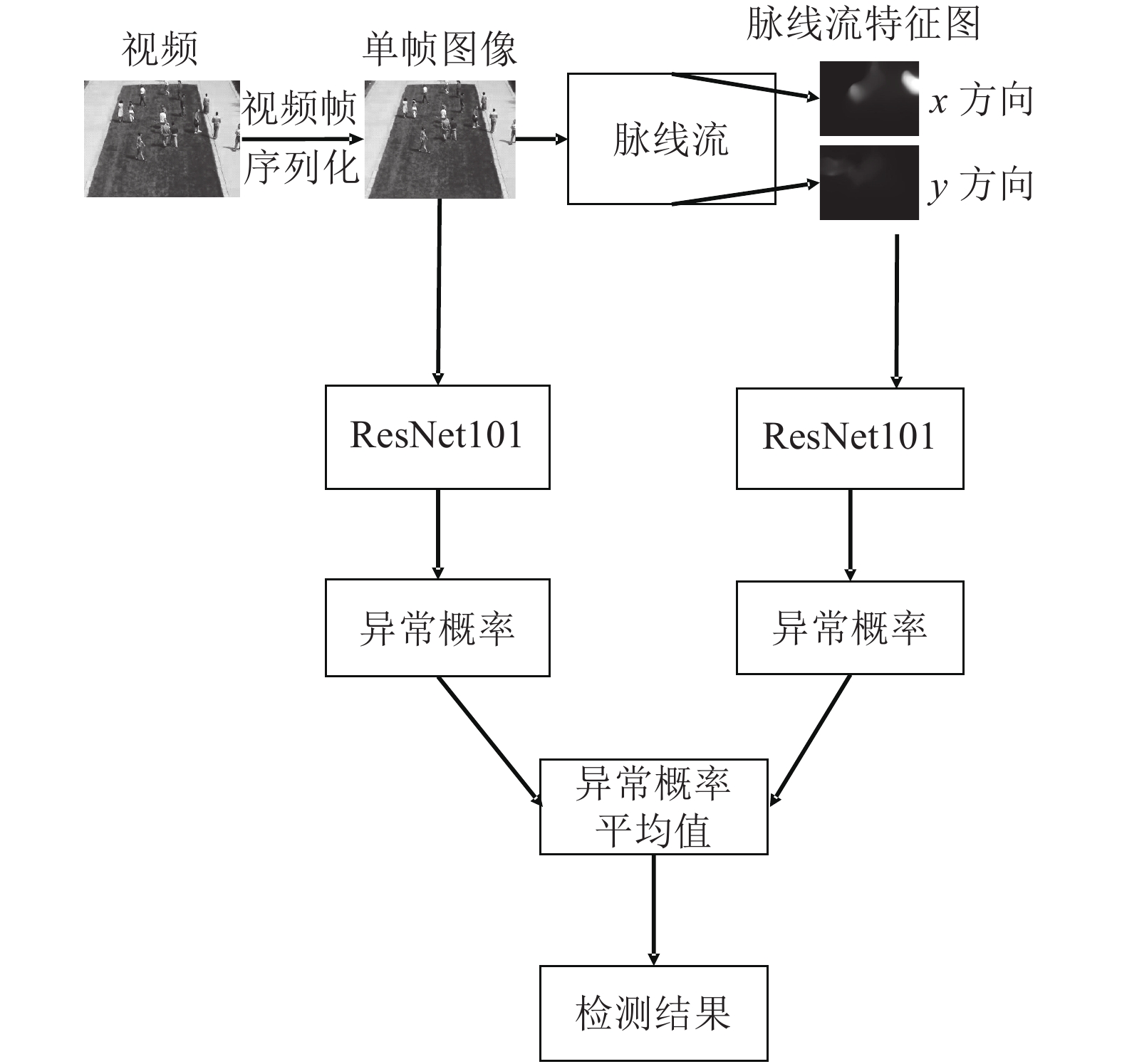

1 方 法本文提出一种基于脉线流卷积神经网络的人群异常行为检测方法(streak flow CNN abnormal behavior detection,简称SFCNN–ABD)。网络结构由两个深度残差网络(ResNet101)作为骨干网络,即空间域网络和时间域网络。其中,空间域网络的输入是原始视频帧,用于提取人群和场景的表观特征;时间域网络的输入是多张相邻帧的脉线流,用以提取人群和场景的运动特征;最后取两路网络的输出平均值进行异常行为检测。算法流程如图1所示。

|

| 图1 SFCNN–ABD流程图 Fig. 1 Framework of the SFCNN–ABD |

1.1 脉线流特征提取

光流特征方法在对运动信息进行描述的过程中,仅能得到连续帧间像素的瞬时运动,不能捕捉长时间段的运动变化;而脉线作为某一时间段内通过某一固定的粒子点的所有粒子的连线,很好地克服了上述问题[13]。因此本文采用基于脉线流的运动特征描述方法。

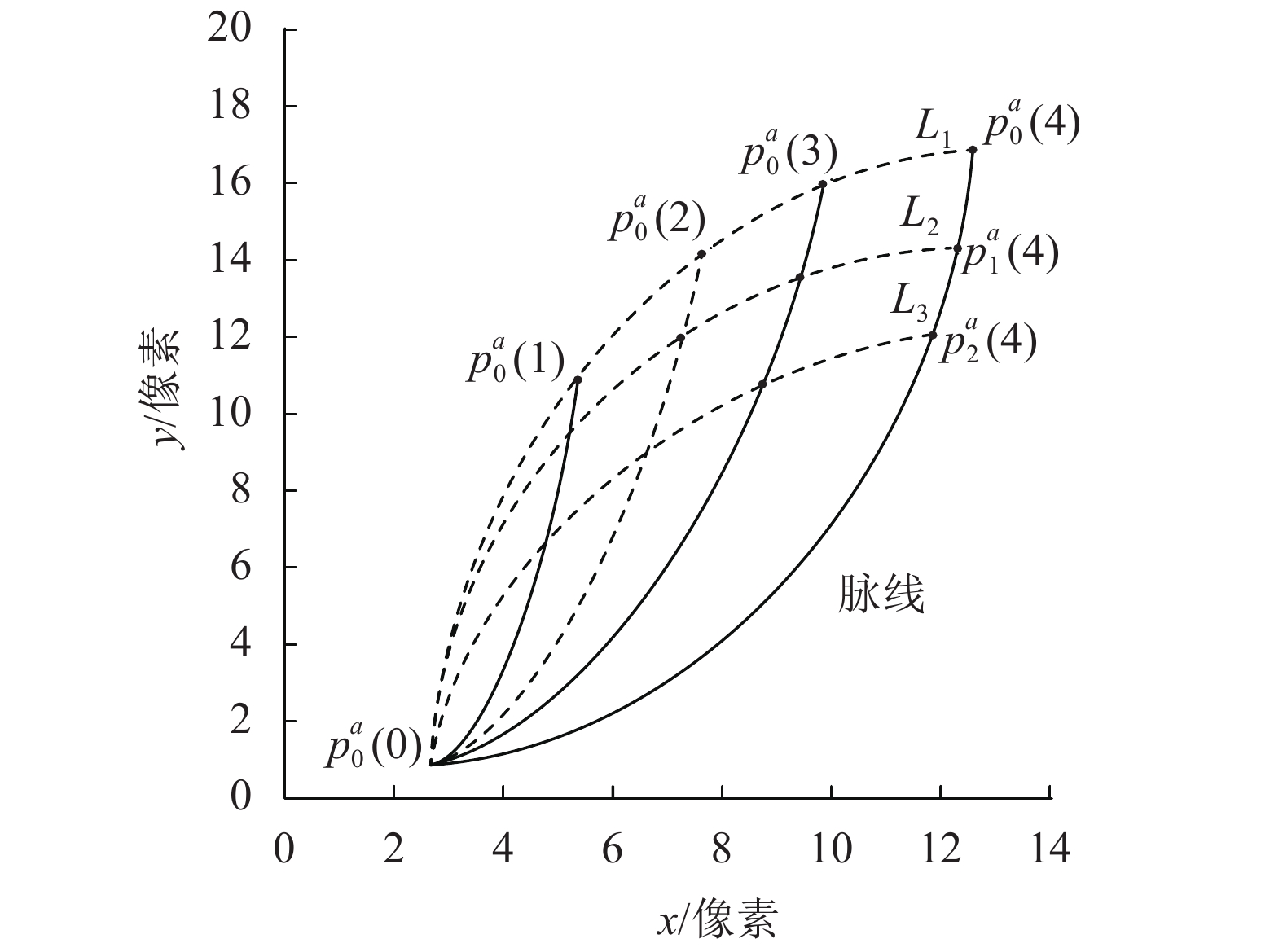

设a为粒子运动的起始点,在0时刻粒子

|

| 图2 脉线示意图 Fig. 2 Schematic diagram of streak line |

在脉线的计算过程中[13],记粒子

| $\left\{\! \begin{array}{l} X_k^a(t{\rm{+}}1) = X_k^a(t){\rm{+}}{{u}}\left( {X_k^a\left( t \right),Y_k^a\left( t \right),t} \right), \\ Y_k^a(t{\rm{+}}1) = Y_k^a(t){\rm{+}}{{v}}\left( {X_k^a\left( t \right),Y_k^a\left( t \right),t} \right) \end{array} \right.$ | (1) |

式中,

设某粒子

| ${A_k}{\rm{ = }}\left\{ {{X_k}\left( t \right),{Y_k}\left( t \right),{{{u}}_k},{{{v}}_k}} \right\}$ | (2) |

式中,

| $\left\{\! \begin{array}{l} {{{u}}_k}{\rm{ = }}{{u}}\left( {X_k^a\left( k \right),Y_k^a\left( k \right),k} \right), \\ {{{v}}_k}{\rm{ = }}{{v}}\left( {X_k^a\left( k \right),Y_k^a\left( k \right),k} \right) \\ \end{array} \right.$ | (3) |

进一步地,在脉线的基础上,可获取其运动场,即脉线流。记

设有广义粒子集合

| ${{{u}}_k}{\rm{ = }}{b_1}{{{u}}_j}\left( {{I_1}} \right)+{b_2}{{{u}}_j}\left( {{I_2}} \right)+{b_3}{{{u}}_j}\left( {{I_3}} \right)$ | (4) |

式中:Is为3个临近像素的索引序号,s=1,2,3;bs为第s个邻近像素的已知三角基函数。基于3个相邻像素点和该粒子的相对位置,通过三角插值公式可求得

| ${{B}}{{{u}}_j}{\rm{ = }}{{U}}$ | (5) |

式中,矩阵

受双流卷积神经网络[9]的启发,本文结合时域运动信息和空间结构信息进行异常行为检测。

考虑到原始双流卷积神经网络仅由5层卷积层和3层全连接层组成,本文引入He等[14]提出的深度残差网络,构造了一种基于深度残差网络ResNet101的脉线流卷积神经网络,使用ResNet101作为原始双流网络的时间域和空间域骨干网络架构,以此提取场景空域信息和时域信息。

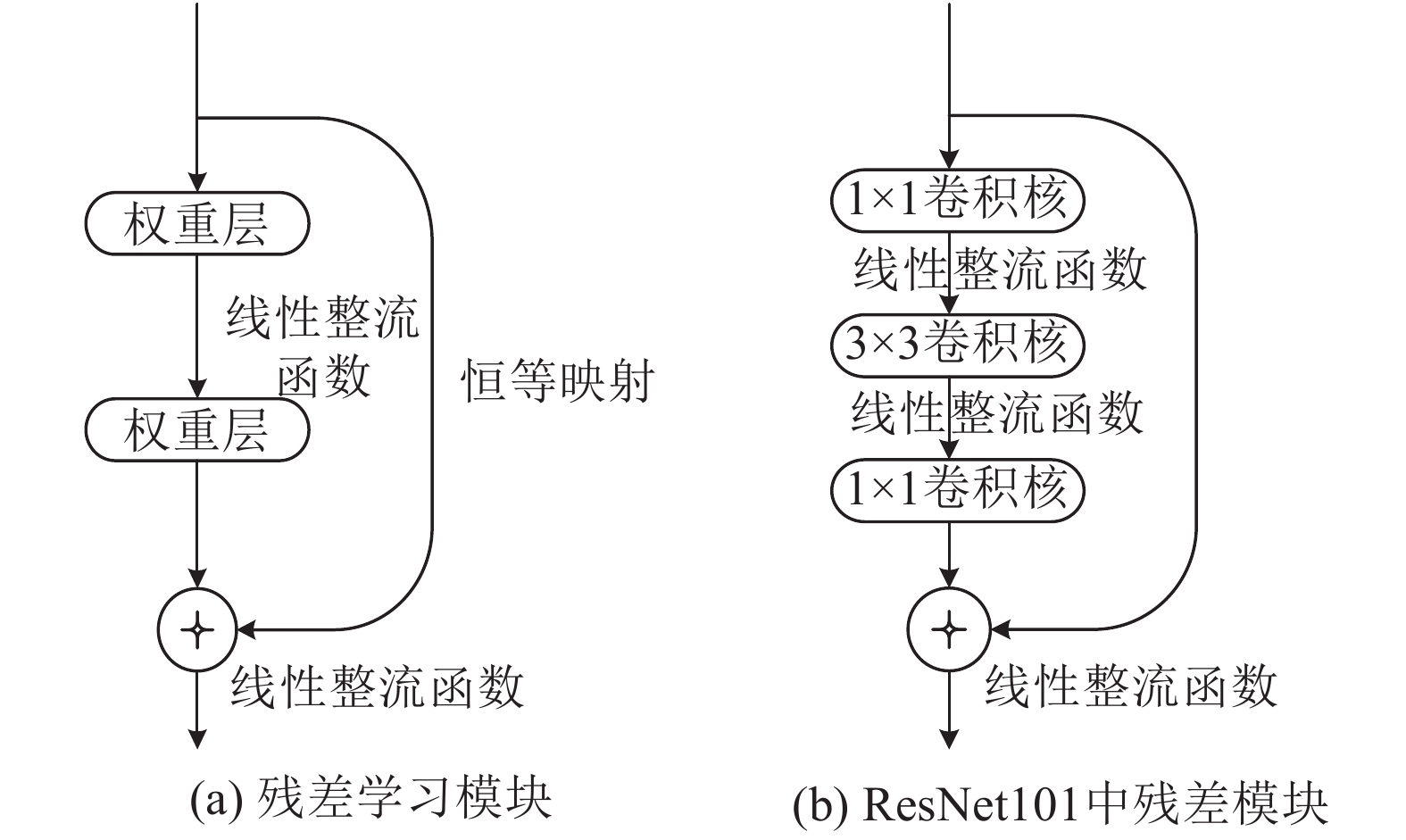

深度残差网络学习算法并不直接拟合网络函数,而是拟合多个卷积层集合的残差函数。如图3(a)所示,He等[14]提出通过残差学习模块扩充网络深度,同时减少网络复杂度。

一个残差学习模块由网络层和恒等映射两部分组成,网络输入先跳跃两层卷积层,再同左侧残差函数进行恒等连接相加操作,其定义如下所示:

| ${{y}}{\rm{ = }}G\left( {{{x}},\left\{ {{{{W}}_i}} \right\}} \right){\rm{+}}{{x}}$ | (6) |

式中:

| $G{\rm{ = }}{{{W}}_2}R\left( {{{{W}}_1}{{x}}} \right)$ | (7) |

式中,R为线性整流函数(ReLU)。

考虑到

| ${{y}}{\rm{ = }}G\left( {{{x}},\left\{ {{{{W}}_i}} \right\}} \right){\rm{+}}{{{W}}_{\rm{s}}}{{x}}$ | (8) |

图3(b)为ResNet101网络中3层卷积层拟合残差函数。首先通过1×1卷积降低输入层网络维度,然后经过3×3卷积学习网络特征,最后通过1×1卷积恢复网络维度。则ResNet101网络中残差模块的表达式如下:

| ${{y}} = {{{W}}_3}R\left( {{{{W}}_2}R\left( {{{{W}}_1}{{x}}} \right)} \right)+{{x}}$ | (9) |

ResNet101网络结构[14]首先使用7×7×64的卷积层,接着由3×3的最大值池化降维,随后再送入33个残差学习模块,经过平均池化后送入全连接层,最后给出分类预测值。

2 实验结果与分析 2.1 实验环境及设计实验硬件环境为:CPU i5/内存8 GB/GPU TeslaK80,深度框架采用Pytorch。

采用人群异常行为检测的公开数据集VIF(violent flow)[11]和UMN(University of Minnesota)[15]验证本文提出方法的有效性。

在上述两个数据集上分别使用光流[6]、脉线流提取人群运动特征,并将获得的特征作为时域流卷积神经网络的输入。其中,脉线流采用堆叠连续5帧数据的方法进行运动特征表示,时域流卷积神经网络的批尺寸(batch_size)设为32,空间流卷积神经网络的batch_size设为20,两个流卷积神经网络的训练次数设为200。实验均采取留n法交叉验证。

为验证本文算法的先进性,实验结果分别同当前主流的HOMO[16]、Fradi et al[17]、AMDN[18]、DiMOLIF[19]及SRC[20]、SF[21]、EM[22]、D–CM[23]等群体异常行为检测算法进行了对比。

2.2 VIF数据集上的实验VIF数据集由以色列开放大学提供,该数据集由来自于YouTube的246个真实录影组成(暴力、非暴力场景个数均为123),主要用于检测人群暴力、非暴力行为。其中,最长的视频6.25 s,最短的为1.04 s,帧速均为25帧/s。本文截取所有视频的前50帧为一个样本,对于长度小于50帧的视频获取25帧为一个样本,共计23个25帧样本和223个50帧样本。

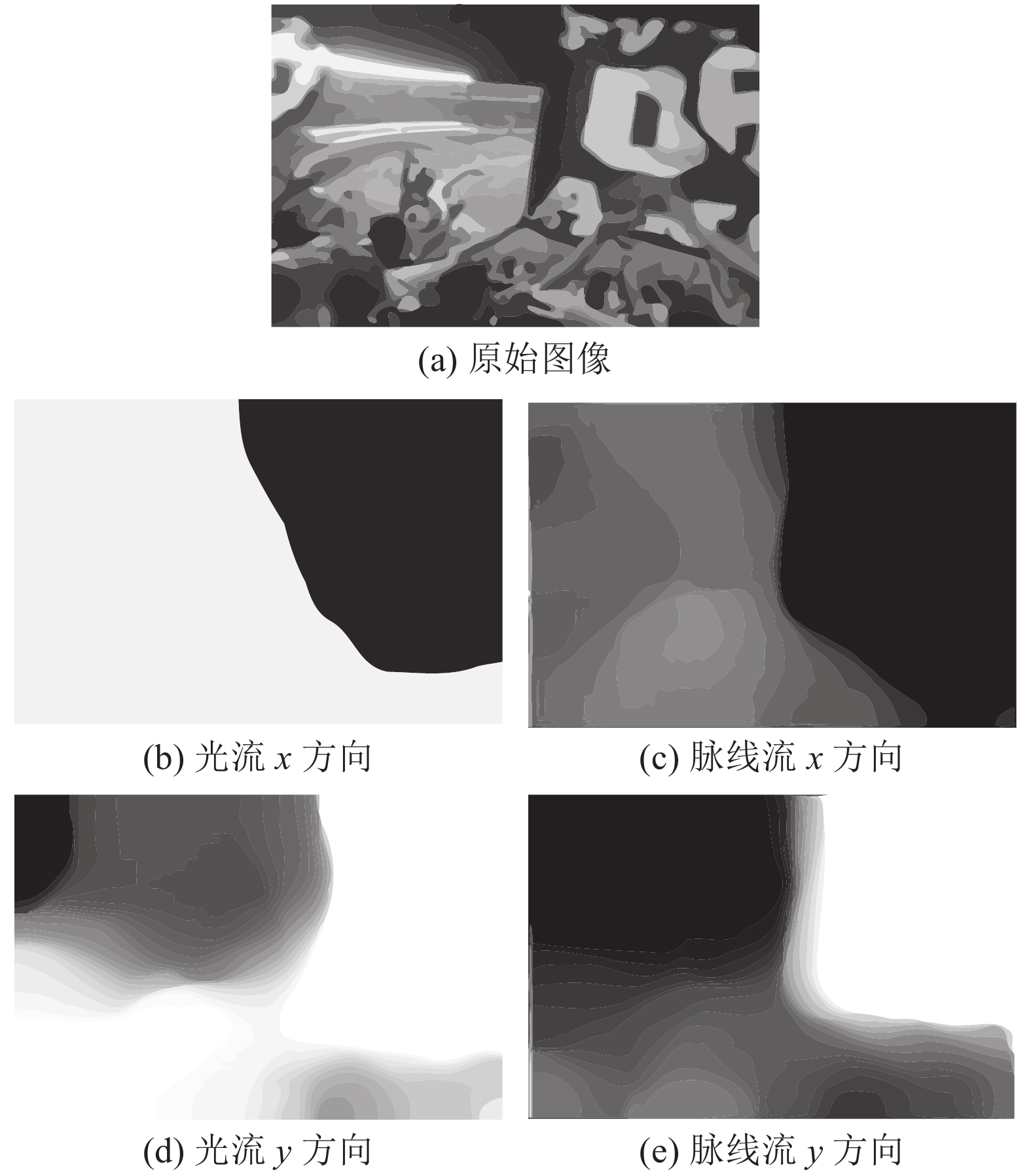

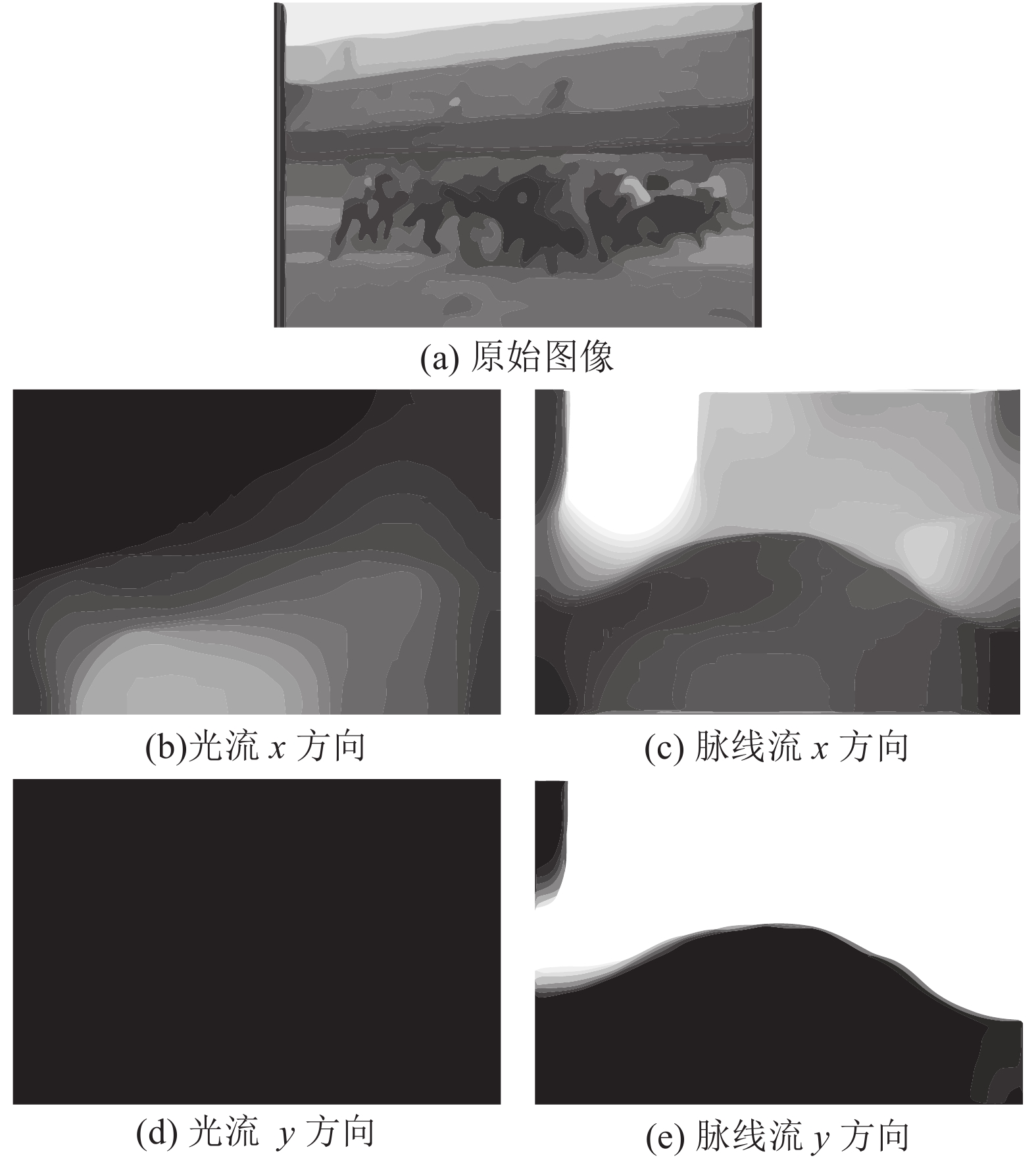

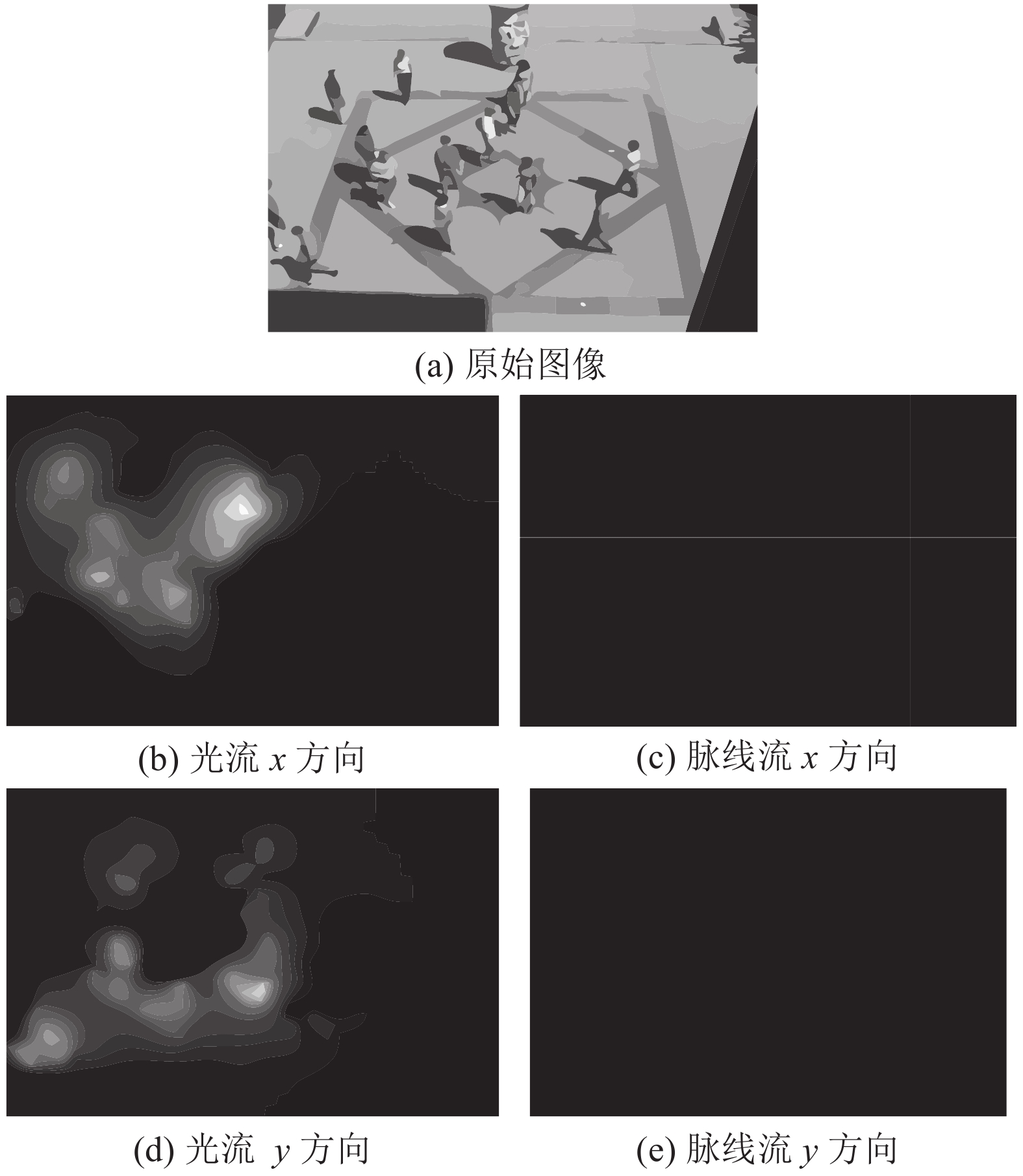

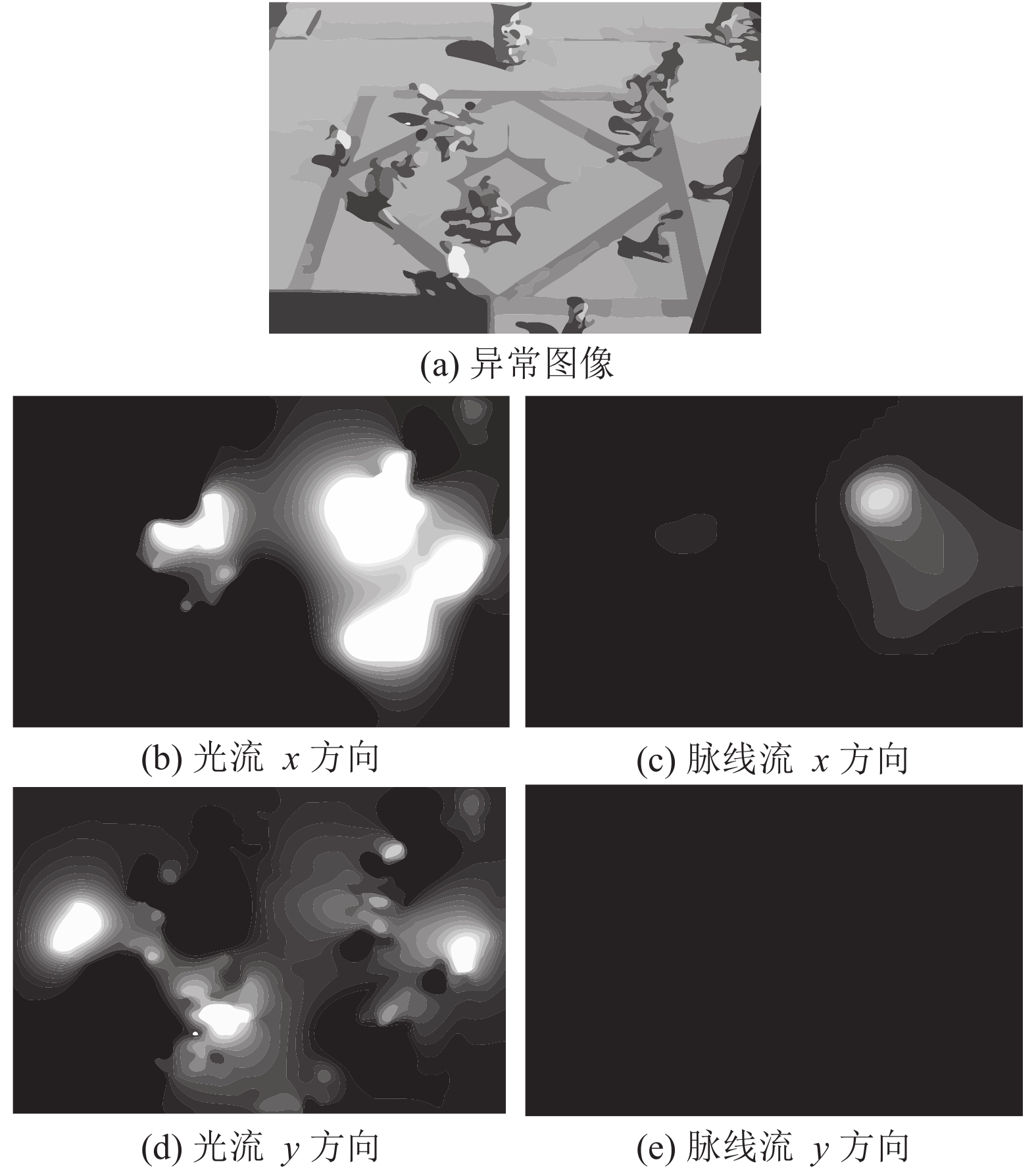

特征提取阶段,使用光流、脉线流对每一帧样本图像进行特征描述,对比了光流法和脉线流法对正常行为和异常行为样本特征表示的不同,分别如图4、5所示。

|

| 图4 VIF数据集中正常行为样本的脉线流和光流特征对比 Fig. 4 Comparison of streak flow and optical flow of normal behavior in VIF dataset |

|

| 图5 VIF数据集中异常行为样本的脉线流和光流特征对比 Fig. 5 Comparison of streak flow and optical flow of abnormal behavior in VIF dataset |

图4展示了上述两种特征表示方法对VIF数据集中正常行为样本的特征表示。图4(a)为从正常行为视频中随机选取的某段连续帧中的第1帧原始图像,图4(b)和(d)分别为该连续帧样本图像在水平和垂直两个方向上的光流法特征,图4(c)和(e)分别为其脉线流特征在水平和垂直两个方向上的表示。

图5展示了上述两种特征表示方法对VIF数据集中异常行为样本的特征表示。图5(a)为从异常行为视频中随机选取的某段连续帧中的第1帧样本原始图像,图5(b)和(d)分别为该段样本对应的水平和垂直方向上的光流法特征,图5(c)和(e)分别为其脉线流特征在水平和垂直两个方向上的表示。

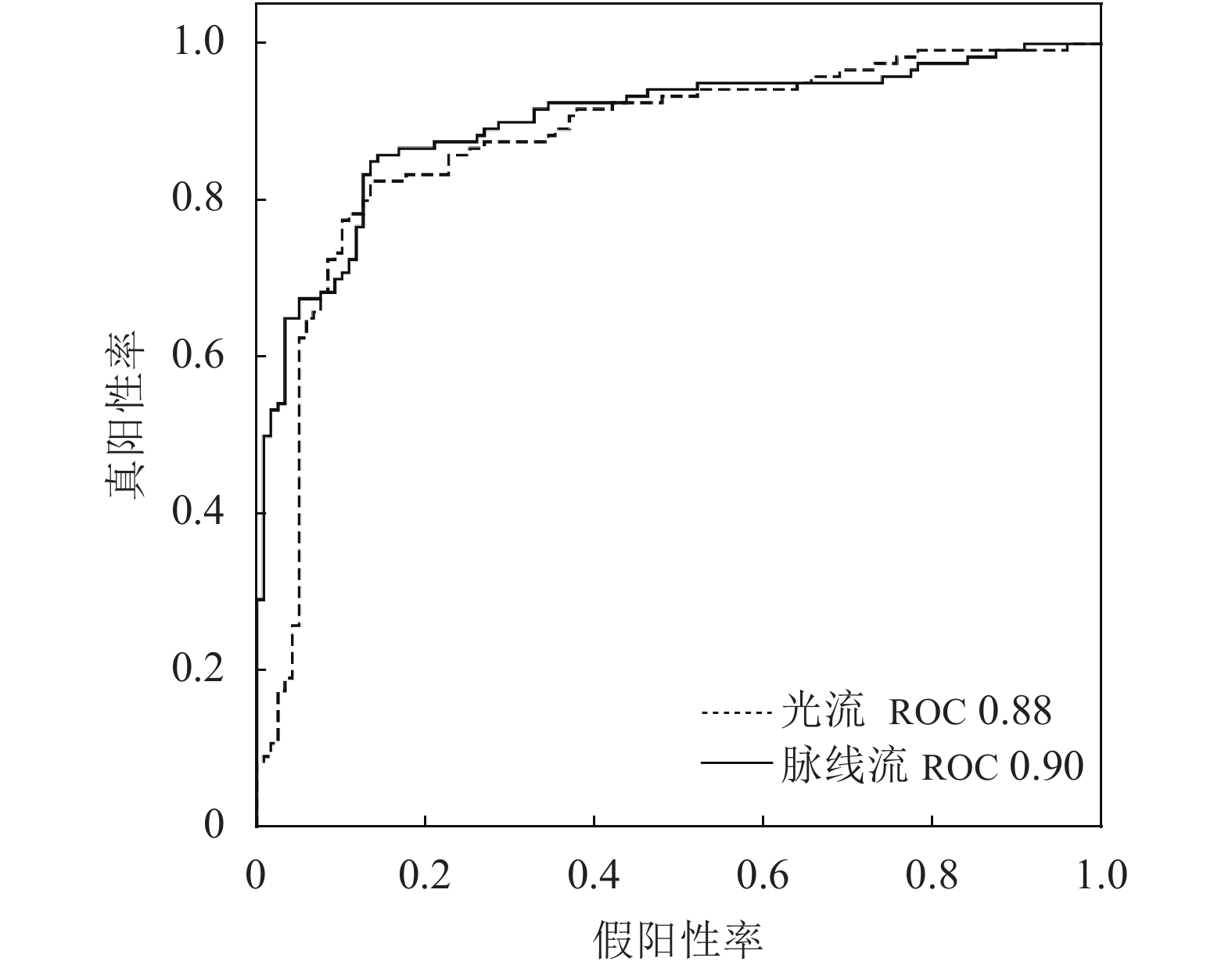

在基于ResNet101的时空流卷积神经网络模型中,对光流法和脉线流法提取的特征得到的异常行为检测模型对比了受试者操作特征曲线(receiver operating characteristic curve,简称ROC曲线),如图6所示。由图6可知,脉线流法ROC值为0.90,光流法ROC值为0.88,脉线流法的检测性能优于光流法。

|

| 图6 光流与脉线流特征在VIF数据集上的ROC曲线对比 Fig. 6 Comparison of ROC curves between streak flow and optical flow in VIF dataset |

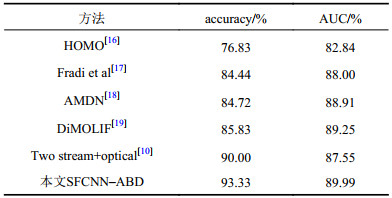

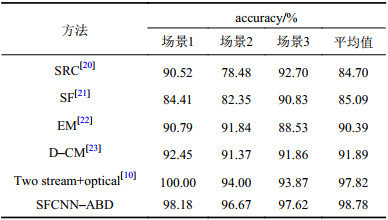

对VIF数据集上进行了8次交叉验证,其中,设n=30。表1为本文提出方法与HOMO[16]、Fradi et al[17]、AMDN[18]、DiMOLIF[19]、Two stream+optical[10]等当前主流方法分别在VIF数据集上的异常检测结果。评价指标为准确度(accuracy)、ROC曲线下面积(area under the curve,AUC)。

| 表1 本文方法与当前主流异常行为检测方法在VIF数据集上的平均精度和AUC对比 Tab. 1 Comparison of detection accuracy and AUC between the proposed method and state-of-the art methods in VIF dataset |

|

2.3 UMN数据集上的实验

UMN数据集由明尼苏达大学提供,该数据集共有7740帧,包含草坪(场景1)、室内大厅(场景2)、广场(场景3)3个不同场景下的人群移动。视频中的正常行为表现为人群的规律走动,而异常行为主要表现为人群突然四散逃离。

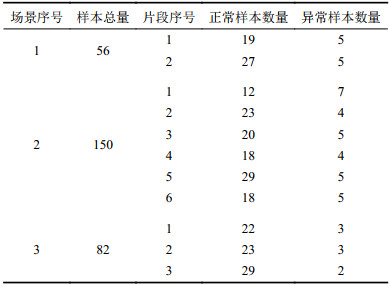

预处理阶段,对删除空白帧(即视频序列中无运动目标)后的所有样本进行截段处理,分为长度为25帧的视频片段,预处理之后的视频样本共计288个,样本具体分布如表2所示。

| 表2 UMN数据集样本分布 Tab. 2 Distribution of samples in UMN |

|

特征提取阶段,使用光流、脉线流对每一帧样本图像进行特征描述。图7展示了上述两种特征表示方法对UMN数据集场景3中正常行为样本的特征表示。图7(a)为从正常行为视频中随机选取的某段连续帧中的第1帧样本原始图像,图7(b)和(d)分别为该段样本图像在水平和垂直两个方向上的光流法特征,图7(c)和(e)分别为脉线流特征在水平和垂直两个方向上的表示。

|

| 图7 UMN数据集中正常行为样本的脉线流和光流特征对比 Fig. 7 Comparison of streak flow and optical flow of normal behavior in UMN dataset |

图8展示了两种特征表示方法对UMN数据集场景3中异常行为样本的特征表示。图8(a)为异常行为视频中随机选取的某段连续帧中的第1帧样本原始图像,图8(b)和(d)分别为该样本对应的水平和垂直方向上的光流法特征,图8(c)和(e)分别为其脉线流特征在水平和垂直两个方向上的表示。

|

| 图8 UMN数据集中异常行为样本的脉线流和光流特征对比 Fig. 8 Comparison of streak flow and optical flow of abnormal behavior in UMN dataset |

类似地,从图7和8中也可以看到脉线流能更好地表征该场景中人群的运动信息。

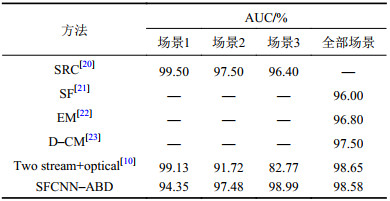

在UMN数据集上,对3个场景分别进行交叉验证,并对整个数据集的全部场景统一进行进行交叉验证,实验结果见图9、10和表3、4。其中:3个不同场景的留n法交叉验证中,n分别为11、30和27;整个数据集的实验中,n=36。

| 表3 本文方法与当前主流异常行为检测方法在UMN数据集上的检测准确度对比 Tab. 3 Comparison of detection accuracy between the proposed method and state-of-the art methods in UMN |

|

| 表4 本文方法与当前主流异常行为检测方法在UMN数据集上的ROC曲线下面积( AUC)对比 Tab. 4 Comparison of AUC between the proposed method and state-of-the art methods in UMN dataset |

|

|

| 图9 本文方法在UMN数据集不同场景下的ROC曲线对比 Fig. 9 Comparison of ROC curves for the proposed method in different scenes of UMN dataset |

|

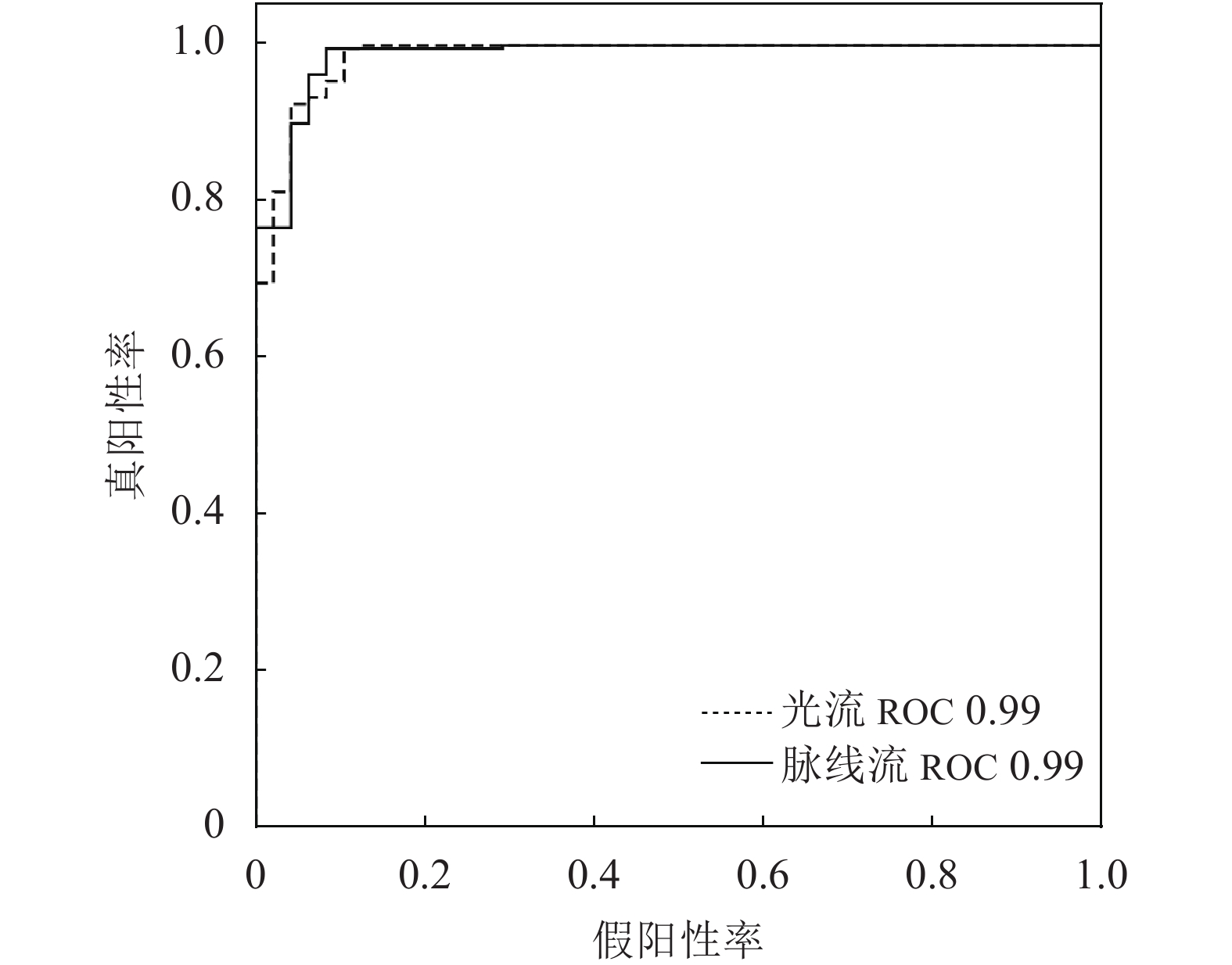

| 图10 光流特征与脉线流特征在UMN数据集全部场景上的ROC曲线对比 Fig. 10 Comparison of ROC curves between streak flow and optical flow in all scenes of UMN dataset |

图9为本文方法在UMN数据集3个不同场景下的ROC曲线对比结果。由图9可以看出,场景1、2、3的ROC值分别为0.94、0.97、0.99,在场景3中本文方法表现最为稳定。主要有两个方面原因造成了3个场景下本文方法所表现出的稳定性不同:一是,3个场景虽然都出现了不同程度的透视问题,由于每个场景中摄像设备和人群的距离不同,使得场景3中透视问题表现最轻微,而场景1则有最为严重的透视问题。二是,由于3个场景中不同的拍摄角度,也造成场景中人群个体之间不同程度的相互遮挡问题,场景3的相互遮挡最少。

图10为光流、脉线流在UMN数据集上对全部场景统一验证后的ROC曲线对比结果,由图10可见,两种特征表示方法稳定性效果相当,ROC值均为0.99。

表3为本文方法SFCNN–ABD与SRC[20]、SF[21]、EM[22]、D–CM[23]、Two stream+optical[10]等当前主流异常检测算法在UMN数据集3个场景的异常检测准确度对比结果。

由表3可以看出,本文方法比当前主流异常检测算法在整体数据集的准确度上有所提升,虽然场景1下准确度略低,但在场景2、3下的准确度更好,其中在场景2下表现最好。

表4为本文方法SFCNN–ABD与SRC[20]、SF[21]、EM[22]、D–CM[23]、Two stream+optical[10]等当前主流异常检测算法对UMN数据集3个场景下ROC曲线下面积(AUC)的对比结果。由表4可以看出:本文方法对UMN数据集3个不同场景的AUC分别为94.35%、97.48%、98.99%,虽然在场景1下表现欠佳,但在场景2、3下模型稳定性都较高,特别是在场景3中表现最好;针对整个数据集检测的AUC为98.58%,仅略微低于Two stream+optical[10]的98.65%。本文方法在场景1中性能相对较低的原因主要是该场景中存在大量具有明显透视问题的数据,因此,在针对场景中的小幅度运动时,光流特征具有扩大运动的效果,而脉线流特征则表现为平滑运动的效果。

3 结 论为了提升人群异常行为检测精度和模型分类性能,提出一种基于脉线流卷积神经网络的检测方法(SFCNN–ABD)。该方法先使用脉线流提取连续帧间的运动信息;然后,将脉线流特征与单帧图像分别作为时空流卷积神经网络中时域流和空间流的输入,并使用深度残差网络(ResNet101)网络作为骨干网络;最后,将两个流的检测结果取平均值,获取最终的检测结果。由检测实验结果可知:SFCNN–ABD在VIF和UMN数据集上的平均准确率及在VIF数据集的AUC值比当前主流方法均有所提升;在UMN数据集上的AUC值仅略微低于Two stream+optical[10],整体优于其他对比算法。

与主流的人群异常行为检测算法相比,本文方法具有以下特点:1)利用脉线流方法提取视频中连续帧的人群运动特征,加强了对动态运动信息的准确获取;2)结合空间和时间特征对人群运动进行判断;3)将ImageNet预训练得到的ResNet101网络运用到双流模型中,加深了检测网络的网络深度,提升检测准确度。但本文算法也存在一定的局限性,由于实际生活中的异常行为样本远少于正常行为样本,因此提升对不均衡样本的处理能力将是下一步工作的研究重点。

| [1] |

Xu Ke,Jiang Xinghao,Sun Tanfeng. Anomaly detection based on stacked sparse coding with intraframe classification strategy[J]. IEEE Transactions on Multimedia, 2018, 20(5): 1062-1074. DOI:10.1109/TMM.2018.2818942 |

| [2] |

Biswas S,Venkatesh Babu R. Anomaly detection via short local trajectories[J]. Neurocomputing, 2017, 242: 63-72. DOI:10.1016/j.neucom.2017.02.058 |

| [3] |

Mousavi H,Nabi M,Kiani H,et al.Crowd motion monitoring using tracklet-based commotion measure[C]//Proceedings of the 2015 IEEE International Conference on Image Processing (ICIP).Quebec City:IEEE,2015:2354–2358.

|

| [4] |

Zhang Keming,Cai Yuanwen,Ren Yuan. Space anomaly events detection approach based on generative adversarial nets[J]. Journal of Beijing University of Aeronautics and Astronautics, 2019, 45(7): 1329-1336. [张克明,蔡远文,任元. 基于生成对抗网络的航天异常事件检测方法[J]. 北京航空航天大学学报, 2019, 45(7): 1329-1336. DOI:10.13700/j.bh.1001-5965.2018.0682] |

| [5] |

Cong Yang,Yuan Junsong,Liu Ji.Sparse reconstruction cost for abnormal event detection[C]//Proceedings of the CVPR 2011.Providence:IEEE,2011:3449–3456.

|

| [6] |

Direkoglu C,Sah M,O’Connor N E.Abnormal crowd behavior detection using novel optical flow-based features[C]//Proceedings of the 2017 14th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS).Lecce:IEEE,2017:1–6.

|

| [7] |

Marques J S,Jorge P M,Abrantes A J,et al.Tracking groups of pedestrians in video sequences[C]//Proceedings of the 2003 Conference on Computer Vision and Pattern Recognition Workshop.Madison:IEEE,2003:101.

|

| [8] |

Tu P,Sebastian T,Doretto G,et al.Unified crowd segmentation[M]//Computer Vision—ECCV 2008.Berlin:Springer,2008:691–704.

|

| [9] |

Brostow G J,Cipolla R.Unsupervised Bayesian detection of independent motion in crowds[C]//Proceedings of the 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR’06).New York:IEEE,2006:594–601.

|

| [10] |

Simonyan K,Zisserman A.Two-stream convolutional networks for action recognition in videos[EB/OL].(2014–06–09)[2020–02–01].https://arxiv.org/abs/1406.2199.

|

| [11] |

Hassner T,Itcher Y,Kliper–Gross O.Violent flows:Real-time detection of violent crowd behavior[C]//Proceedings of the 2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.Providence:IEEE,2012:1–6.

|

| [12] |

Xiong Raorao,Hu Xuemin,Chen Long,et al. Abnormal crowd behavior detection using synthesized optical flow histogram[J]. Computer Engineering, 2017, 43(10): 228-233. [熊饶饶,胡学敏,陈龙,等. 利用综合光流直方图的人群异常行为检测[J]. 计算机工程, 2017, 43(10): 228-233. DOI:10.3969/j.issn.1000-3428.2017.10.038] |

| [13] |

Mehran R,Moore B E,Shah M.A streakline representation of flow in crowded scenes[M]//Computer Vision—ECCV 2010.Berlin:Springer,2010:439–452.

|

| [14] |

He Kaiming,Zhang Xiangyu,Ren Shaoqing,et al.Deep residual learning for image recognition[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas:IEEE,2016:770–778.

|

| [15] |

Minnesota University.Unusual crowd activity dataset of University of Minnesota[CP/OL].[2020–02–01].http://mha.cs.umn.edu/movies/crowdactivity-all.avi.

|

| [16] |

Mahmoodi J,Salajeghe A. A classification method based on optical flow for violence detection[J]. Expert Systems with Applications, 2019, 127: 121-127. DOI:10.1016/j.eswa.2019.02.032 |

| [17] |

Fradi H,Luvison B,Pham Q C. Crowd behavior analysis using local mid-level visual descriptors[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(3): 589-602. DOI:10.1109/TCSVT.2016.2615443 |

| [18] |

Xu Dan,Ricci E,Yan Yan,et al.Learning deep representations of appearance and motion for anomalous event detection[EB/OL].(2015–10–06)[2020–02–01].https://arxiv.org/abs/1510.01553.

|

| [19] |

Ben Mabrouk A,Zagrouba E. Spatio-temporal feature using optical flow based distribution for violence detection[J]. Pattern Recognition Letters, 2017, 92: 62-67. DOI:10.1016/j.patrec.2017.04.015[LinkOut] |

| [20] |

Cong Yang,Yuan Junsong,Liu Ji. Abnormal event detection in crowded scenes using sparse representation[J]. Pattern Recognition, 2013, 46(7): 1851-1864. DOI:10.1016/j.patcog.2012.11.021 |

| [21] |

Mehran R,Oyama A,Shah M.Abnormal crowd behavior detection using social force model[C]//Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition.Miami:IEEE,2009:935–942.

|

| [22] |

Xiong Guogang,Wu Xinyu,Chen Y L,et al.Abnormal crowd behavior detection based on the energy model[C]//Proceedings of the 2011 IEEE International Conference on Information and Automation.Shenzhen:IEEE,2011:495–500.

|

| [23] |

Zhou Bolei,Tang Xiaoou,Zhang Hepeng,et al. Measuring crowd collectiveness[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(8): 1586-1599. DOI:10.1109/TPAMI.2014.2300484 |

2020, Vol. 52

2020, Vol. 52